- May 06 / 2019

- Comments Off on Seputar Big Data edisi #71

Apache, Artificial Intelligece, Big Data, Implementation, machine learning, Spark

Seputar Big Data edisi #71

Kumpulan berita, artikel, tutorial dan blog mengenai Big Data yang dikutip dari berbagai site. Berikut ini beberapa hal menarik yang layak untuk dibaca kembali selama minggu I bulan Mei 2019

Artikel dan berita

- Serbu! Kemenkominfo Buka 25 Ribu Beasiswa Big Data Cs Gratis

Kementerian Komunikasi dan Informatika (Kemenkominfo) menggagas beasiswa pelatihan melalui Digital Talent Scholarship 2019 bagi 25 ribu peserta. Pelatihan itu meliputi bidang-bidang seperti artificial intelligence (AI), big data, cloud computing, cyber security, internet of things, dan machine learning. - Facebook lets select researchers access ‘privacy-protected’ data

Facebook memberikan akses khusus terhadap lebih dari 60 peneliti yang dipilih oleh 2 organisasi mitra, Social Science One dan Social Science Research Council (SSRC). Para peneliti tersebut dapat mengakses data yang dilindungi privasi tersebut untuk penelitian mengenai pengaruh media sosial terhadap demokrasi. - Visualizing Disparities: How Mapping and Big Data Can Provide Insight into Social Equity Indicators

Big data dan informasi geolokasi telah terbukti bermanfaat dalam persiapan dan penanganan bencana. Informasi tersebut juga dapat digunakan untuk mendapatkan insight terhadap komunitas, dan mengidentifikasi berbagai faktor yang mempengaruhi kualitas hidup masyarakat di wilayah tertentu, dengan cara seperti yang diuraikan dalam artikel ini. - Harvard AI determines when tuberculosis becomes resistant to common drugs

Tuberkulosis (TB) adalah salah satu penyakit paling mematikan di dunia. Pada tahun 2017 tercatat hampir 10 juta orang terinfeksi, dan 1,3 juta kematian terkait TB. Bakteri yang menyebabkan TB pun sulit untuk ditarget karena kemampuannya untuk mengembangkan resistensi terhadap obat tertentu. Para peneliti di Blavatnik Institute di Harvard Medical School telah merancang pendekatan komputasi yang mampu mendeteksi resistensi terhadap obat TB yang biasa digunakan, dengan kecepatan dan akurasi yang sangat baik. - From drone swarms to modified E. Coli: say hello to a new wave of cyberattacks

Para peneliti menciptakan malware berbasis AI yang dapat digunakan untuk menghasilkan gambar kanker palsu yang dapat menipu dokter yang paling ahli sekalipun. Dengan malware ini, pasien yang sehat bisa jadi akan mendapatkan kemoterapi dan radiasi, sedangkan pasien kanker justru akan dipulangkan begitu saja. Contoh ini menunjukkan bahwa serangan data adalah senjata nuklir abad ke-21. Lebih dari penguasa wilayah, siapapun yang menguasai data mampu memanipulasi perasaan dan pikiran masyarakat. Untuk itu pengambil kebijakan perlu memahami lebih baik resiko keamanan yang dapat muncul dari penggunaan AI.

Tutorial dan pengetahuan teknis

- Generative and Analytical Models for Data Analysis

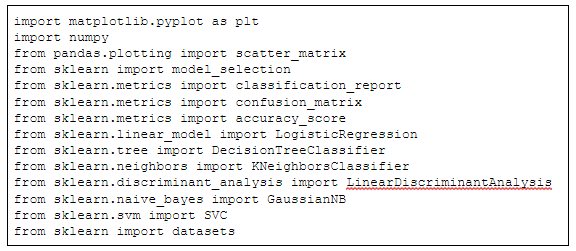

Artikel ini memberikan penjelasan yang sangat baik mengenai dua pendekatan data analisis yaitu generatif dan analitikal, perbedaan antara keduanya serta apa pentingnya. Dijelaskan juga mengenai apa bagian yang seringkali ‘hilang’ dalam proses data analisis, yang menghambat kesuksesan proses tersebut. - How to Implement VGG, Inception and ResNet Modules for Convolutional Neural Networks from Scratch

Terdapat beberapa model jaringan saraf convolutional yang telah terbukti berhasil dan berkinerja baik dalam menyelesaikan permasalahan seperti klasifikasi citra. Beberapa model di antaranya menggunakan komponen yang diulang berkali-kali seperti misalnya blok VGG dalam model VGG, modul inception dalam GooLeNet, dan model residual dalam ResNet. Artikel ini menjelaskan mengenai implementasi model-model tersebut dari 0. - Detailed Guide to the Bar Chart in R with ggplot

Pemilihan jenis grafik untuk menampilkan hasil analisis sangat menentukan kejelasan dan efektivitas penyajian informasi. Salah satu jenis grafik yang paling sederhana namun powerful adalah bar chart. Artikel ini menjelaskan penggunaan ggplot untuk membuat bar chart yang sesuai dengan kebutuhan kita. - Why Your Spark Apps Are Slow Or Failing, Part II: Data Skew and Garbage Collection

Bagian kedua dari serial artikel ini membahas mengenai permasalahan-permasalahan yang muncul dari data skew dan garbage collection dalam Spark. - Optimizing Kafka Streams Applications

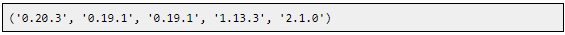

Rilis Kafka 2.1.0 memperkenalkan framework optimisasi topologi prosesor pada layer Kafka Stream DSL. Artikel ini menjelaskan mengenai topologi prosesor pada Kafka versi sebelumnya, issue yang muncul yang terkait efisiensi, dan solusinya di versi 2.1.0. Dibahas pula mengenai bagaimana menyalakan optimisasi ini dalam proses upgrade Kafka. - Normalization vs Standardization — Quantitative analysis

Salah satu issue yang penting machine learning adalah feature scaling atau penskalaan fitur. Dua metode yang paling banyak dibahas adalah normalisasi dan standarisasi. Artikel ini menyajikan eksperimen untuk mencoba menjawab beberapa pertanyaan terkait pemilihan kedua metode tersebut dan dampaknya terhadap model yang dihasilkan. - Improving Uber’s Mapping Accuracy with CatchME

Transportasi andal membutuhkan peta yang akurat, yang menyediakan layanan seperti routing, navigasi, dan perhitungan perkiraan waktu kedatangan (ETA). Error pada peta dapat mengganggu layanan dan kepuasan pengguna. Uber berbagi pengalaman mengenai pemanfaatan berbagai feedback untuk meningkatkan kualitas peta, khususnya penggunaan GPS trace untuk mengenali inkonsistensi dalam data peta, dengan sistem yang dinamakan CatchMapError (CatchME).

Rilis Produk

- Facebook launches PyTorch 1.1 with TensorBoard support

Facebook meluncurkan PyTorch 1.1 dengan dukungan TensorBoard dan peningkatan kompiler just-in-time (JIT). PyTorch 1.1 hadir dengan API baru, dukungan untuk tensor Boolean, recurrent neural networks kustom, dan peningkatan kompiler JIT untuk mengoptimalkan grafik komputasi. - Open Sourcing Delta Lake

Delta Lake adalah layer penyimpanan yang menjanjikan keandalan untuk data lake yang dibangun di atas HDFS dan penyimpanan cloud dengan menyediakan transaksi ACID melalui kontrol konkurensi optimis antara penulisan dan isolasi snapshot untuk pembacaan yang konsisten selama penulisan. Delta Lake juga menyediakan built-in data versioning untuk rollbacks dan pembuatan reports yang lebih mudah.Delta Lake tersedia di http://delta.io untuk diunduh dan digunakan di bawah Lisensi Apache 2.0. - RStudio 1.2 Released

Versi ini dirilis setelah lebih dari setahun development, mencakup banyak peningkatan dan kemampuan baru. Di antaranya, RStudio menjanjikan workbench yang lebih nyaman untuk SQL, Stan, Python, dan D3. Testing kode R yang lebih mudah dengan integrasi untuk shinytest dan testthat. Pembuatan, testing dan publish API dalam R dengan Plumber, serta dukungan background job untuk peningkatan produktivitas. - Apache SINGA (incubating) 2.0.0 Released

Apache SINGA adalah platform umum deep learning terdistribusi untuk melakukan training terhadap big deep learning model dengan dataset yang besar. Rilis ini mencakup beberapa penambahan fitur. - Apache Beam 2.12.0 released

Rilis ini mencakup beberapa penambahan fitur, peningkatan, dan perbaikan bugs. - The Apache Software Foundation Announces Apache® SkyWalking™ as a Top-Level Project

Apache Skywalking adalah tool Application Performance Monitor (APM) yang digunakan di Alibaba, China Eastern Airlines, Huawei, dan lain-lain. Memasuki Apache inkubator pada Desember 2017, baru-baru ini SkyWalking dinyatakan sebagai top level project Apache.

Contributor :

Tim idbigdata

always connect to collaborate every innovation 🙂

always connect to collaborate every innovation 🙂