- Feb 21 / 2018

- Comments Off on Seputar Big Data Edisi #49

Uncategorized

Seputar Big Data Edisi #49

Kumpulan berita, artikel, tutorial dan blog mengenai Big Data yang dikutip dari berbagai site. Berikut ini beberapa hal menarik yang layak untuk dibaca kembali selama minggu ketiga bulan Februari 2017

Artikel dan Berita

-

- AirAsia Teams Up with GE for Big Data Analytics in the Sky

AirAsia telah mengumumkan perjanjian empat tahun dengan GE. GE Aviation akan menyediakan Electronic Flight Operations Quality Assurance (eFOQA) dan aplikasi pilot FlightPulse untuk armada AirAsia yang terdiri dari sekitar 355 pesawat A320 dan A330 serta 4.000 orang pilot. - How to Use Blockchain and Big Data for Better Small Business Profits

Dengan teknologi blockchain, usaha kecil dan menengah bisa memanfaatkan analisis big data tanpa harus khawatir dengan biaya atau kompleksitas. Bagaimana cara pemanfaatan blockchain dan big data untuk industri kecil dan menengah? - Big Companies Are Embracing Analytics, But Most Still Don’t Have a Data-Driven Culture

Selama 6 tahun NewVantage Partners melakukan survey terhadap 57 perusahaan besar dari berbagai bidang. Enam tahun lalu fokus survey adalah big data, namun tahun ini fokus survey beralih ke Artificial Intelligence. Meskipun demikian, inti permasalahan tetap sama : ledakan data dan bagaimana memanfaatkannya. Bagaimana hasil survey tersebut? - Deep learning neural network used to detect earthquakes

Sebuah tim peneliti dari Harvard University dan MIT menggunakan teknologi jaringan syaraf tiruan untuk mendeteksi gempa bumi, dan menemukan metode ini lebih akurat daripada metode saat ini. Dalam penelitian ini para peneliti melatih sebuah deep learning neural network untuk membaca seismogram dan bagaimana membedakan antara gerakan rutin “noise” dan gempa bumi. Jaringan saraf yang dinamai ConvNetQuake ini mengidentifikasi 17 kali lebih banyak gempa daripada yang tercatat dalam katalog gempa Survei Geologi Oklahoma.

- AirAsia Teams Up with GE for Big Data Analytics in the Sky

Tutorial dan Pengetahuan Teknis

- 5 Things Dealers Need to Understand About Big Data

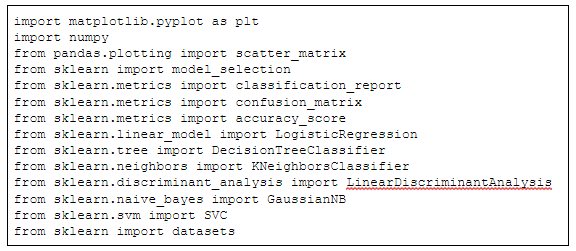

Wawancara dengan beberapa eksekutif di bidang dealership mengenai big data, apa nilai strategisnya bagi para dealer, dan bagaimana penerapan big data yang tepat serta kesalahan apa yang sering dilakukan perusahaan dealer dalam penerapan big data ini. - Introduction to Python Ensembles

Ensemble menjadi salah satu metode paling populer dalam pembelajaran mesin terapan. Hampir setiap solusi pemenang Kaggle menggunakannya, dan banyak pipeline data sains memiliki ansambel di dalamnya. Artikel ini menampilkan dasar-dasar ensamble -apa dan mengapa mereka dapat bekerja dengan sangat baik- dan memberikan tutorial langsung untuk membangun ensemble dasar. - Apache Ignite: Setup Guide

Artikel singkat mengenai setup Apache Ignite. - 5 Fantastic Practical Machine Learning Resources

Artikel ini menyajikan 5 sumber praktis mengenai machine learning, yang mencakup pembelajaran mesin dari dasar, pengkodean algoritma dari nol maupun menggunakan framework machine learning tertentu. - Managing Large State in Apache Flink: An Intro to Incremental Checkpointing

Artikel ini memberikan overview mengenai arsitektur di balik fitur incremental checkpoint Apache Flink. Flink memanfaatkan RocksDB untuk status lokal, dan mencatat sstables (file format yang digunakan untuk menyimpan data) mana yang perlu dibackup untuk membuat snapshot. - Comparison of the Open Source OLAP Systems for Big Data: ClickHouse, Druid and Pinot

Perbandingan antara ClickHouse, Druid, dan Pinot. Ketiganya adalah engine OLAP storage terdistribusi yang open-source. Dalam artikel ini dibahas secara cukup mendalam mulai dari persamaan, kinerja, dan beberapa perbedaan penting dalam hal data ingestion, replikasi dan eksekusi query. - Dynamometer: Scale Testing HDFS on Minimal Hardware with Maximum Fidelity

LinkedIn menguji kinerja Apache Hadoop DFS sebelum meng-upgrade versinya, dengan menggunakan alat load-testing yang disebut Dynamometer. Tool ini mensimulasikan beban produksi dengan bootstrap dari image FS NameNode, menjalankan sejumlah besar simulasi DataNode, dan menjalankan kembali operasi nyata berdasar log audit HDFS. Dynamometer ini sekarang tersedia di github. - Machine Learning Algorithms for Business Applications – Complete Guide

Artikel yang cukup komprehensif mengenai berbagai aalgoritma machine learning, lengkap dengan kekurangan dan kelebihannya dalam penerapan untuk dunia bisnis. - A Gentle Introduction to Matrix Operations for Machine Learning

Banyak algoritma machine learning menggunakan operasi matriks dalam deskripsinya. Beberapa operasi digunakan secara langsung untuk memecahkan persamaan, sementara yang lain memberikan stuktur atau landasan yang berguna dalam deskripsi dan penggunaan operasi matriks yang lebih kompleks. Tutorial ini menjelaskan operasi matriks aljabar linear yang penting, yang digunakan dalam deskripsi metode machine learning.

Rilis Produk

-

- Apache Lens 2.7.1

Apache Lens versi 2.7.1 mencakup support Java 8, perbaikan pada konfigurasi per user dalam job scheduler, cube segmentation, retry untuk recover dari erroe transient, dan support UNION anntar tabel fact, serta beberapa perbaikan bug. - Apache Oozie 4.3.1 released

Apache Oozie 4.3.1 mencakup beberapa bug fixes dan peningkatan minor.

- Apache Lens 2.7.1

Contributor :

Tim idbigdata

always connect to collaborate every innovation 🙂

always connect to collaborate every innovation 🙂