- Dec 29 / 2017

- Comments Off on Seputar Big Data Edisi #44 [Kilas Balik 2017]

Apache, Artificial Intelligece, Big Data, Blockchain, Hadoop, Implementation, IoT

Seputar Big Data Edisi #44 [Kilas Balik 2017]

Edisi terkahir di tahun 2017 akan menampilkan beberapa berita yang dikutip dari berbagai site selama tahun 2017 yang akan sangat menarik jika dibaca kembali. Mulai dengan rilis baru Hadoop 3.0, penerapan Big Data di pemerintahan Indonesia seperti BI, Dirjen Pajak dan PT POS hingga berita tentang sebuah robot yang memperoleh status kewarganegaraan.

-

The Apache Software Foundation Announces Apache® Hadoop® v3.0.0 General Availability

Apache Hadoop 3.0.0 akhirnya dirilis minggu lalu. Beberapa fitur penting yang ditambahkan adalah HDFS erasure encoding, a preview dari v2 YARN Timeline Service, peningkatan YARN/HDFS Federation, dan lain sebagainya. -

Big Data Is the New Push for Bank Indonesia

Seperti halnya bank central di negara lain seperti Rusia, China, Inggris dan lainnya, Bank Indonesia beralih menggunakan mesin atau yang sering disebut dengan istilah Big Data, untuk membantu membuat kebijakan menjadi lebih efektif. -

Usai Paradise Papers, DJP Bakal Punya Big Data Pajak dari AEoI

Direktorat Jenderal Pajak (DJP) Kementerian Keuangan akan memiliki data dengan skala besar dan valid dari otoritas pajak seluruh negara saat implementasi pertukaran data secara otomatis (Automatic Exchange of Information/AEoI) per September 2018 -

PT Pos Bangun Big Data Analytic

Hingga kini, baru 36 persen masyarakat Indonesia yang memiliki akun bank. Sedangkan 64 persen masyarakat yang tinggal di pelosok belum tersentuh keuangan inklusif karena sulitnya akses ke perbankan. Untuk membantu masyarakat tersebut, PT Pos tengah membangun big data analytic. Lewat big data analytic, Pos akan membuat kredit skoring yang nantinya bisa dikerjasamakan dengan perbankan untuk penyaluran pembiayaan. -

Saudi Arabia grants citizenship to a robot for the first time ever

Sebuah berita cukup menjadi sorotan, dimana sebuah robot bernama Sophia diberi status kewarganegaraan oleh pemerintah Arab Saudi. Hal ini merupakan sebuah tonggak sejarah akan kebangkitan teknologi AI. -

Top Trends in the Gartner Hype Cycle for Emerging Technologies, 2017

Garner merilis The Gartner Hype Cycle for Emerging Technologies 2017, yang berfokus pada 3 mega trend, yaitu Artificial Intelligent, Transparently Immersive Experiences dan Digital Platforms. Para arsitek dan inovator teknologi harus mengeksplorasi dan memahami 3 mega trend tersebut untuk dapat melihat dampaknya terhadap bisnis. -

How Big Data Mines Personal Info to Craft Fake News and Manipulate Voters

Banyak orang memasang atau membagikan status dan content lain di media sosial dengan maksud mempengaruhi orang lain. Tapi bagaimana jika justru status dan posting kita itu dipergunakan untuk mempengaruhi kita sendiri? Cambridge Analytica, salah satu perusahaan di balik kampanye Donald Trump, mengungkapkan mengenai “psychographic profiling”, yaitu memanfaatkan data-data sosial media untuk membentuk kampanye yang sesuai dengan profil emosi dan psikologis pengguna sosial media. -

The 10 Coolest Big Data Startups Of 2017 (So Far)

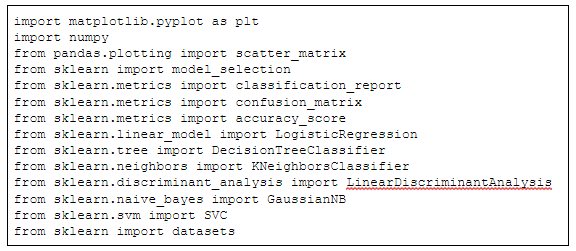

Banyak startup yang bermain di area big data memfokuskan diri untuk memberikan solusi terhadap masalah dalam menghubungkan sumber data yang berbeda dan memindahan data ke dalam cloud untuk memudahkan akses dan analisa. Ada juga tren yang sedang berkembang yaitu penggunaan machine learnig dan artificial intelligence dalam aplikasi big data untuk membuat sistem yang lebih cerdas. -

What Amazon taught us this week: Data-centric companies will devour competitors

Apa sebenarnya keuntungan yang bisa didapatkan Amazon dengan akuisisi jaringan retail Whole Foods, terutama dari sisi penguasaan data dan pemanfaatannya? Berikut ini analisis dan beberapa pelajaran yang didapat dari langkah yang diambil Amazon tersebut. -

Guizhou to become China’s ‘Big Data Valley’

Akhir Mei lalu puluhan ribu pengunjung memadati “International Big Data Industry Expo 2017” yang diselenggarakan di Guizhou, China. Saat ini Guizhou dikembangkan sebagai “Big Data Valley”-nya China, yang menjadi tempat yang menarik bukan hanya bagi start-up, namun juga bagi industri besar seperti misalnya Alibaba, Qualcomm, IBM, Huawei, Tencent, Baidu, Lenovo dan Foxconn. -

Cloudera Announces Pricing of Initial Public Offering, Marking its Debut as a Public Company

Cloudera memulai hari sebagai sebuah perusahaan terbuka dengan melakukan penawaran saham perdana seharga $15. Pada akhir hari mengalami peningkatan harga sebesar 20%. -

Firing on All Cylinders: The 2017 Big Data Landscape

Pada tahun 2017 ini adalah sebuah phase penerapan Big Data dalam segala bidang, yang membuat istilah Big Data itu sendiri berangsur menghilang. “Big Data + AI” menjadi suatu pasangan yang digunakan banyak aplikasi modern yang dibangun, baik untuk penerapan terhadap konsumen maupun perusahaan. -

Gartner’s 2017 Take on Data Science Software

Gartner telah merilis Gartner Magic Quadran for Data Science Platforms 2017. Dari sekitar 100 perusahaan yang menjual software data sains, Gartner memilih 16 perussahaan yang memiliki pendapatan tinggi atau pendapatan rendah tetapi pertumbuhan yang tinggi. Setelah mendapat masukan baik dari pelanggan maupun perwakilan perusahaan, Gartner memberikan nilai pada perusahaan dengan kriteria “kelengkapan visi” dan “kemampuan untuk melaksanakan” visi tersebut.

Contributor :

Tim idbigdata

always connect to collaborate every innovation 🙂

always connect to collaborate every innovation 🙂