- Dec 14 / 2017

- Comments Off on Seputar Big Data Edisi #41

Apache, Big Data, IoT, Spark, Uncategorized

![]()

Seputar Big Data Edisi #41

Kumpulan berita, artikel, tutorial dan blog mengenai Big Data yang dikutip dari berbagai site. Berikut ini beberapa hal menarik yang layak untuk dibaca kembali selama minggu pertama bulan Desember 2017

Artikel dan Berita

- Uber’s Uber Breach: A Stunning Failure In Corporate Governance And Culture

Ketika Uber mengetahui data mereka bocor di akhir 2016 lalu, selain tidak memperingatkan pihak-pihak yang terkena dampaknya, mereka juga berusaha berkonspirasi untuk menutupi kasus tersebut. Bahkan mereka pun bersedia membayar hacker/pemeras yang membobol data mereka dalam usaha menyembunyikannya. Dalam artikel ini Forrester mengupas mengenai kasus tersebut. - The Marine Biologist Using Big Data to Protect Ocean Wildlife

Bagaimana para ahli biologi kelautan menggunakan big data untuk menjaga keragaman dan keseimbangan hayati kelautan dengan membangun beberapa platform untuk memonitor berbagai ancaman terhadap ekosistem laut. - Big Data in Marketing; 5 Use Cases – There Are a Lot More Than Just Five

5 contoh penggunaan big data dalam bidang marketing. - Big data: Three ways to turn business intelligence into a business advantage

Besarnya informasi yang dimiliki sebuah organisasi tidak selalu sejalan dengan jumlah insight yang mereka dapatkan. Dalam artikel ini CIO perusahaan retail House of Fraser memaparkan mengenai strategi mereka dalam menempatkan BI dan AI sebagai pendukung utama dalam pengambilan keputusan dalam perusahaan.

Tutorial dan Pengetahuan Teknis

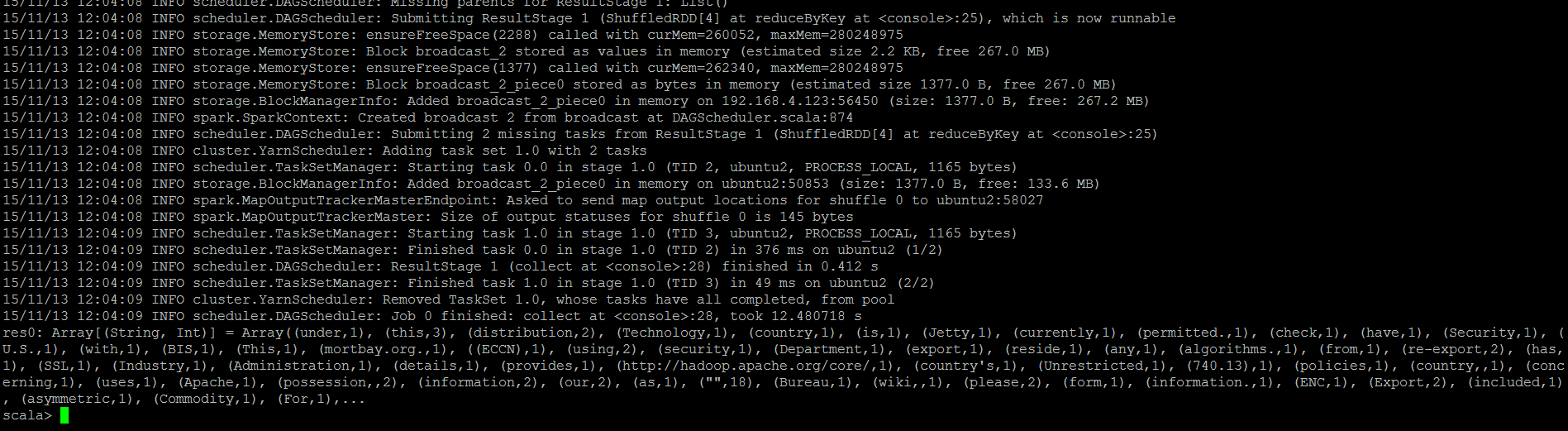

- Graph Analytics Using Big Data

Sebuah overview dan tutorial singkat mengenai bagaimana melakukan analisis graph menggunakan Apache Spark, graphframe dan Java. - From lambda to kappa and dataflow paradigms

Sebuah tinjauan singkat mengenai evolusi kerangka pemrosesan data dalam beberapa tahun terakhir ini, mulai dari framework yang sudah muncul lebih dulu (misalnya Storm dan Samza) serta beberapa framework baru seperti Beam, Spark, dan Flink. - Comparing Pulsar and Kafka: unified queuing and streaming

Overview mengenai Apache Pulsar (incubating) dan perbandingannya dengan Apache Kafka. - scikit-learn: Creating a Matrix of Named Entity Counts

Artikel yang menjelaskan mengenai implementasi model menggunakan named entities dan polyglot NLP library dari scikit-learn untuk mengikuti kompetisi Kaggle Spooky Author Identification. - Transfer learning from multiple pre-trained computer vision models

Dalam deep learning, sebuah model perlu dilatih menggunakan data yang besar untuk dapat digunakan. Semakin besar data yang digunakan untuk training model, semakin baik kinerjanya untuk data baru. Salah satu metode yang paling murah dan praktis adalah dengan ‘transfer learning’. Artikel ini menjelaskan bagaimana menggunakan model computer vision yang sudah ditraining, dalam keras TensorFlow abstraction library. - Data acquisition in R (3/4)

Seri ke 3 dari 4 artikel yang menjelaskan dengan sangat baik mengenai akuisisi data (loading, preproses, analisis dan visualisasi) dalam R, terutama data-data yang berhubungan dengan demografi. - [FREE EBOOK] The Ultimate Guide to Basic Data Cleaning

Data cleansing atau data cleaning merupakan langkah yang sangat penting dalam pengolahan data, karena kualitas insight yang dihasilkan dari proses analisis tergantung dari kualitas datanya. Ebook ini menjelaskan mengenai dasar-dasar data cleaning dalam 8 bab yang singkat, dilengkapi dengan contoh kasus. - [DATASET] IMDB 5000 Movie Dataset

Dataset yang digunakan untuk mengeksplorasi kemungkinan untuk memprediksi popularitas sebuah film sebelum film tersebut dirilis.

Rilis Produk

- Apache ZooKeeper 3.4.11

Rilis Apache ZooKeeper 3.4.11 mencakup beberapa bug fixes dan peningkatan kinerja. - Apache BooKeeper 4.5.1 Released

Versi 4.5.1 dari Apache BooKeeper dirilis minggu ini. Di dalamnya terdapat penyelesaian terhadap beberapa bug kritikal. - Apache Bigtop 1.2.1

Apache Bigtop 1.2.1 dibangun di atas JDK8 dan mencakup Docker provisioner serta peningkatan pada beberapa project ekosistemnya. -

Burrow 1.0.0 Released

Burrow adalah tool monitoring untuk Apache Kafka. Versi 1.0.0 yang baru-baru ini dirilis mencakup beberapa fitur baru dan perbaikan bugs. -

StreamSets Data Collector 3.0

StreamSet merilis versi 3.0 dari SDC (StreamSet Data Collector), dan Data Collector Edge yang baru. Data Collector Edge adalah versi lightweight binary dari SDC. SDC versi 3.0 mencakup beberapa fitur baru yang berhubungan dengan Kafka, Google Cloud, Oracle CDC, MapR, dan lain sebagainya.